Ngày 12/3, Google giới thiệu Gemma 3, mô hình AI mã nguồn mở thế hệ thứ 3, có khả năng hoạt động trên cả điện thoại thông minh và máy trạm hiệu suất cao.

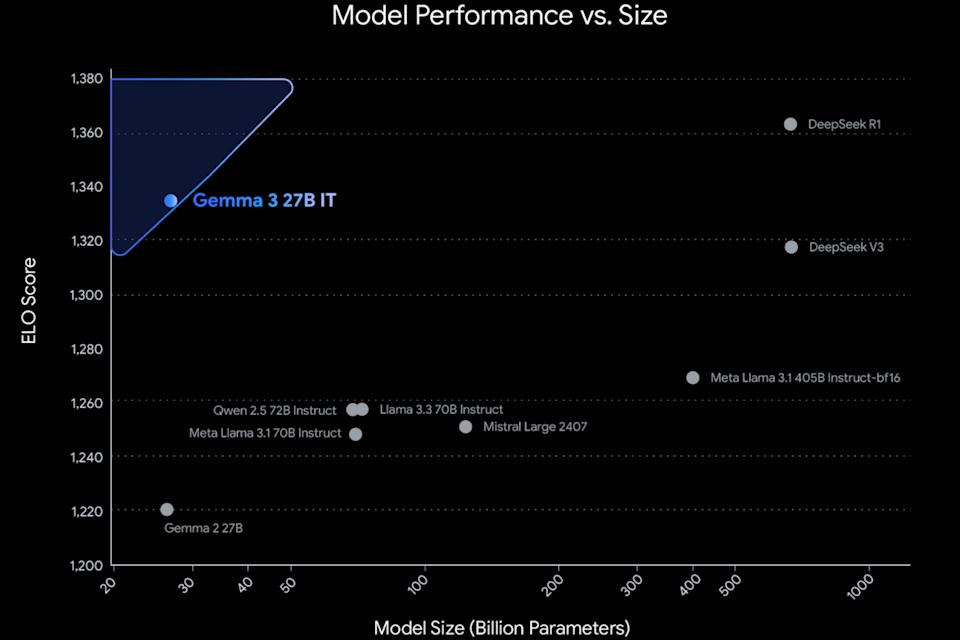

Gemma 3 được ra mắt với 4 biến thể gồm 1 tỷ, 4 tỷ, 12 tỷ và 27 tỷ tham số. Theo Google, đây là mô hình đơn tăng tốc tốt nhất thế giới, có thể chạy trên một GPU hoặc TPU duy nhất thay vì yêu cầu một cụm máy tính lớn.

Về lý thuyết, điều này cho phép Gemma 3 chạy trực tiếp trên đơn vị lõi xử lý Tensor (TPU) của điện thoại Pixel, tương tự cách mô hình Gemini Nano vận hành cục bộ trên thiết bị di động.

So với dòng mô hình AI Gemini, lợi thế lớn nhất của Gemma 3 là tính mã nguồn mở, giúp các nhà phát triển dễ dàng tùy chỉnh, đóng gói và triển khai theo nhu cầu trong các ứng dụng di động và phần mềm máy tính. Ngoài ra, Gemma hỗ trợ hơn 140 ngôn ngữ, trong đó 35 ngôn ngữ đã có sẵn dưới dạng gói huấn luyện.

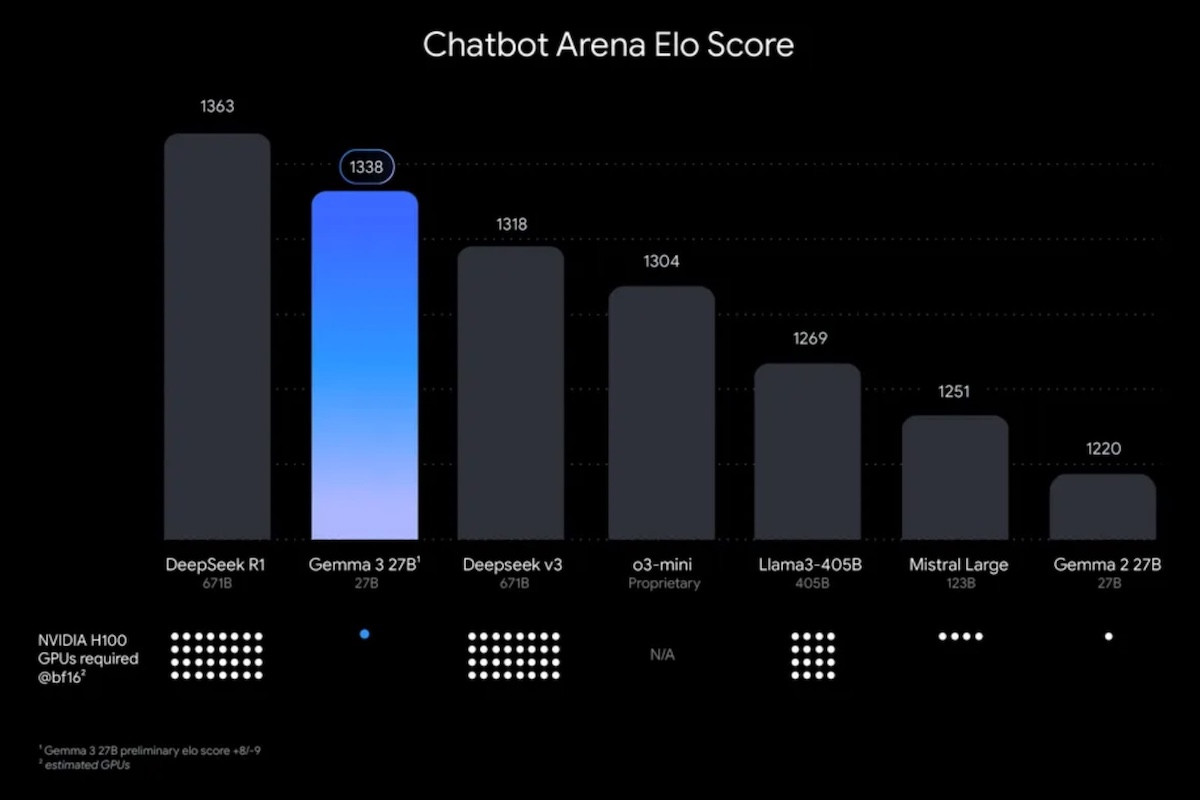

Tương tự như các mô hình Gemini 2.0 mới nhất, Gemma 3 có khả năng xử lý văn bản, hình ảnh và video. Về hiệu suất, Gemma 3 được đánh giá cao hơn so với nhiều mô hình AI mã nguồn mở phổ biến khác, bao gồm DeepSeek V3, OpenAI o3-mini và biến thể Llama-405B của Meta.

Ngữ cảnh tương đương 200 trang sách

Gemma 3 hỗ trợ cửa sổ ngữ cảnh lên đến 128.000 token, tương đương với lượng dữ liệu của một cuốn sách dày 200 trang. Trong khi đó, để so sánh, mô hình Gemini 2.0 Flash Lite có cửa sổ ngữ cảnh lên đến 1 triệu token.

Gemma 3 có thể tương tác với các tập dữ liệu bên ngoài và hoạt động như một tác nhân tự động, tương tự cách Gemini hỗ trợ công việc trên các nền tảng như Gmail hay Docs một cách liền mạch.

Các mô hình AI mã nguồn mở mới nhất của Google có thể được triển khai cục bộ hoặc thông qua các dịch vụ đám mây của công ty, chẳng hạn như Vertex AI. Hiện tại, Gemma 3 đã có sẵn trên Google AI Studio, cũng như các nền tảng bên thứ ba như Hugging Face, Ollama và Kaggle.

Mô hình nguồn mở thế hệ thứ 3 của Google là một phần của xu hướng trong ngành, nơi các công ty phát triển song song cả mô hình ngôn ngữ lớn (LLM) và mô hình ngôn ngữ nhỏ (SLM). Microsoft, đối thủ của Google, cũng đang theo đuổi chiến lược tương tự với dòng mô hình ngôn ngữ nhỏ mã nguồn mở Phi.

Các mô hình ngôn ngữ nhỏ như Gemma và Phi được đánh giá cao về hiệu suất sử dụng tài nguyên, giúp chúng trở thành lựa chọn lý tưởng để chạy trên các thiết bị như điện thoại thông minh. Ngoài ra, với độ trễ thấp hơn, chúng đặc biệt phù hợp cho các ứng dụng di động.

Nguồn: https://vietnamnet.vn/google-ra-mat-gemma-3-mo-hinh-ai-ma-nguon-mo-voi-hieu-suat-vuot-troi-2380097.html